Web Scraping

Web Scraping con Web Scraper - Todo lo que necesita aprender

Todo sobre web scraping y web scraper son increíbles y cruciales. Encuentre la información más detallada en este blog.

Jul 01, 2024Carlos Rivera

¿Qué es el Web Scraping?

El web scraping es un proceso automatizado utilizado para recopilar grandes volúmenes de datos de sitios web. También se conoce comúnmente como extracción de datos web o scraping de datos web.

El web scraping requiere dos partes: un crawler y un scraper.

- Un crawler es un algoritmo de inteligencia artificial que navega por las páginas web siguiendo enlaces en internet para buscar datos específicos necesarios.

- Un scraper es una herramienta creada específicamente para extraer datos de sitios web. El diseño de un scraper puede diferir significativamente según la complejidad y escala del proyecto, asegurando que pueda extraer datos de manera rápida y precisa.

De hecho, si alguna vez has copiado e insertado datos de un sitio web, básicamente has realizado la misma tarea que un web scraper. La única diferencia es que tú terminaste el scraping de datos manualmente.

Aunque el web scraping puede hacerse manualmente, en la mayoría de los casos se prefieren las herramientas automatizadas porque son más económicas y trabajan más rápido.

El web scraping utiliza aprendizaje automático y automatización inteligente para recuperar cientos, millones o incluso miles de millones de puntos de datos extraídos de los límites aparentemente infinitos de internet.

Sin embargo, cabe destacar que es inevitable encontrarse con bloqueos de sitios web y CAPTCHAs al realizar web scraping.

Reconoce fácilmente CAPTCHAs y desbloquea para un scraping web sin problemas.

Empieza a usar Nstbrowser gratis ahora!

¿Tienes ideas y dudas interesantes sobre el web scraping y el Browserless?

¡Veamos qué comparten otros desarrolladores en Discord y Telegram!

Scraper y Crawler - ¿Cuál es la diferencia?

Aquí tomamos un enfoque más comprensible: el buey y el arado.

El crawler juega el papel del buey, guiando al scraper (también conocido como el arado) en nuestro reino digital.

Es decir, el crawler guiará al scraper a través de internet extrayendo los datos necesarios como si fuera una operación manual.

El web crawler

Un web crawler, a veces llamado "spider", es el programa básico que navega por la web y busca e indexa contenido.

Navega por internet haciendo clic en enlaces y explorando para indexar y buscar contenido. En muchos programas, primero "rastreas" la web o un sitio específico para descubrir URLs, que luego se pasan al scraper.

El web scraper

El web scraper es una herramienta especializada diseñada para extraer datos e información relevante de páginas web de manera precisa y rápida. Los scrapers web varían mucho en diseño y complejidad, dependiendo del proyecto.

¿Cómo funciona el Web Scraper?

Entonces, ¿cómo funciona un web scraper? El proceso parece relativamente simple, pero en realidad es un poco complicado. Después de todo, los sitios web están diseñados para humanos, no para máquinas.

Cuando un web scraper necesita rastrear un sitio web:

- Antes del scraping, el scraper obtiene uno o más URLs para cargar, y luego carga todo el código HTML de esos sitios. Algunos scrapers más avanzados renderizarán todo el sitio, quizás incluso extrayendo todos los elementos de CSS y Javascript.

- El scraper luego toma los datos necesarios del código HTML, o datos específicos seleccionados por el usuario antes de ejecutar el proyecto, y los presenta en un formato especificado por el usuario. Este dato se presenta en un formato especificado por el usuario.

Normalmente, el usuario necesitará seleccionar los datos específicos que desea de la página. En otras palabras, solo deseas rastrear las páginas de productos de Amazon para obtener precios y números de modelo, pero no estás necesariamente interesado en las reseñas de productos.

En la mayoría de los casos, el web scraper exportará los datos a una hoja de cálculo CSV o Excel, mientras que los más avanzados admitirán otros formatos, como JSON listo para API.

- Finalmente, el web scraper exportará todos los datos que recopila a un formato que sea más útil para el usuario.

¿Qué tipos de web scrapers existen?

- Autoconstruidos

- Preconstruidos

- Extensiones de navegador

- Software de computadora

- Interfaz de usuario

- Cloud web scraper

Web scraper autoconstruido

Al igual que construir un sitio web, cualquiera puede construir su propio web scraper. Pero requiere ciertos conocimientos avanzados de programación. Si deseas un crawler más efectivo, necesitas un conocimiento más profundo de programación.

Web scraper preconstruido

Lo opuesto al autoconstruido son los web scrapers preconstruidos, que generalmente tienen opciones avanzadas personalizables. Solo necesitas descargarlos y ejecutarlos fácilmente. La programación del scraping, JSON y las exportaciones de Google Sheets son características comunes en los web scrapers preconstruidos.

Web scraper como extensión de navegador

Una extensión de navegador es un programa como una aplicación que se puede agregar a tu navegador, como Google Chrome o Firefox. Lo bueno de este tipo de scraper es que se integra con tu navegador, por lo que es muy fácil de ejecutar y operar.

Sin embargo, cualquier característica avanzada que esté más allá del alcance de tu navegador no funcionará en la extensión del navegador. Esto significa que la rotación de IP no es posible al usarla.

¡Nstbrowser realiza la rotación de IP de manera inteligente, desbloqueando sitios web sin esfuerzo!

¡Pruébalo GRATIS ahora!

Web scraper como software de computadora

Aunque los scrapers de software de computadora no son tan convenientes como las extensiones, no están limitados por lo que los navegadores pueden o no pueden hacer.

Dado que se pueden descargar e instalar en tu computadora, son más complejos que los web scrapers que operan dentro de un navegador. Sin embargo, también poseen características sofisticadas que no están limitadas por las restricciones de un navegador.

Web scraper con interfaz de usuario

El web scraper con interfaz de usuario es una herramienta de scraping web que incluye una interfaz fácil de usar. Los usuarios pueden ingresar URLs, establecer parámetros y ver resultados sin necesidad de escribir código directamente. Estos web scrapers suelen ser más fáciles de usar para la mayoría de las personas con conocimientos técnicos limitados.

Cloud web scraper

Un web crawler local se ejecutará en tu computadora utilizando sus recursos y conexión a internet. Esto significa que si tu comportamiento de scraping requiere un alto rendimiento de CPU y RAM, tu computadora puede volverse muy lenta mientras ejecuta el scraper.

Para evitar este problema, existe el cloud web scraper.

El cloud web scraper extrae datos de sitios web sin utilizar los recursos de tu computadora. Esto ayuda a que tu computadora se concentre en otras tareas.

¿Para qué se puede utilizar el Web Scraping?

1. Investigación de mercado

¿Qué están haciendo tus clientes? ¿Y tus clientes potenciales? ¿Cómo se compara la fijación de precios de tus competidores con la tuya?

Los datos de calidad capturados en el sitio web pueden ser muy útiles para una empresa en el análisis de los consumidores y en la planificación del rumbo que debe seguir la empresa en el futuro.

- Recopilar datos de sitios de comercio electrónico sobre productos, precios y reseñas de consumidores.

- Monitorear los sitios web de los competidores para rastrear sus precios, lanzamientos de productos y promociones.

- Extraer precios de acciones, informes financieros y noticias del mercado para análisis de inversiones.

2. Seguimiento de contenido

Nada es más valioso que mantenerse informado. Desde monitorear reputaciones hasta rastrear tendencias industriales, el web scraping es una herramienta invaluable para mantenerse informado. La información necesita ser rastreada y sincronizada con la tecnología de web scraping.

- Recopilar artículos de noticias de diversas fuentes para mostrar en una sola plataforma.

- Agregar ofertas de trabajo de múltiples tableros de empleo en una base de datos buscable.

- Compilar información sobre propiedades de diferentes sitios web de bienes raíces.

3. Propósitos académicos e investigación

- Minería de datos: Recopilar grandes conjuntos de datos para investigación académica, como recopilar publicaciones científicas o datos estadísticos.

- Análisis de sentimientos: Las empresas pueden usar web scrapers para recopilar datos de sitios de redes sociales como Facebook y Twitter para realizar análisis de sentimientos y minería de opiniones sobre los consumidores mediante la extracción de publicaciones, reseñas de productos o artículos de noticias.

4. Monitoreo y alertas

- Monitoreo de precios: Seguimiento de los cambios en los precios de los productos con el tiempo y configuración de alertas para reducciones de precios.

- Monitoreo de sitios web: Seguimiento de los cambios en el contenido del sitio web, como actualizaciones de Términos de Servicio o nuevos lanzamientos de productos.

5. Automatización empresarial

- Envío de formularios: Automatizar el proceso de completar y enviar formularios en tu sitio web.

- Actualización de contenido: Actualizar automáticamente la información en tu propio sitio web mediante el scraping de datos de otras fuentes.

6. Análisis empresarial

- Generación de leads: Recopilar información de contacto y otros detalles relevantes de sitios web con fines de ventas y marketing.

- Visión del cliente: Analizar reseñas y comentarios de clientes para obtener información sobre preferencias y puntos problemáticos de los clientes.

7. Comercio electrónico

- Información del producto: Capturar detalles del producto, especificaciones e imágenes para crear catálogos de productos.

- Seguimiento de inventario: Monitorear niveles de inventario y disponibilidad de productos de diferentes proveedores.

8. SEO y marketing digital

- Análisis de palabras clave: Extraer palabras clave de los sitios web de competidores para estrategias de SEO.

- Análisis de backlinks: Recopilar datos de backlinks para comprender estrategias de construcción de enlaces y mejorar los rankings en los motores de búsqueda.

9. Viajes y hospitalidad

- Comparación de precios: Comparar precios de vuelos, hoteles y alquiler de autos en diferentes sitios web de viajes.

- Agregación de reseñas: Recopilar reseñas de hoteles, restaurantes y atracciones para sitios web de planificación de viajes.

10. Acceso a datos públicos

- Datos gubernamentales: Extraer datos públicos de sitios web gubernamentales para análisis e informes.

- Datos abiertos: Recolectar datos de portales de datos abiertos para usar en diversas aplicaciones.

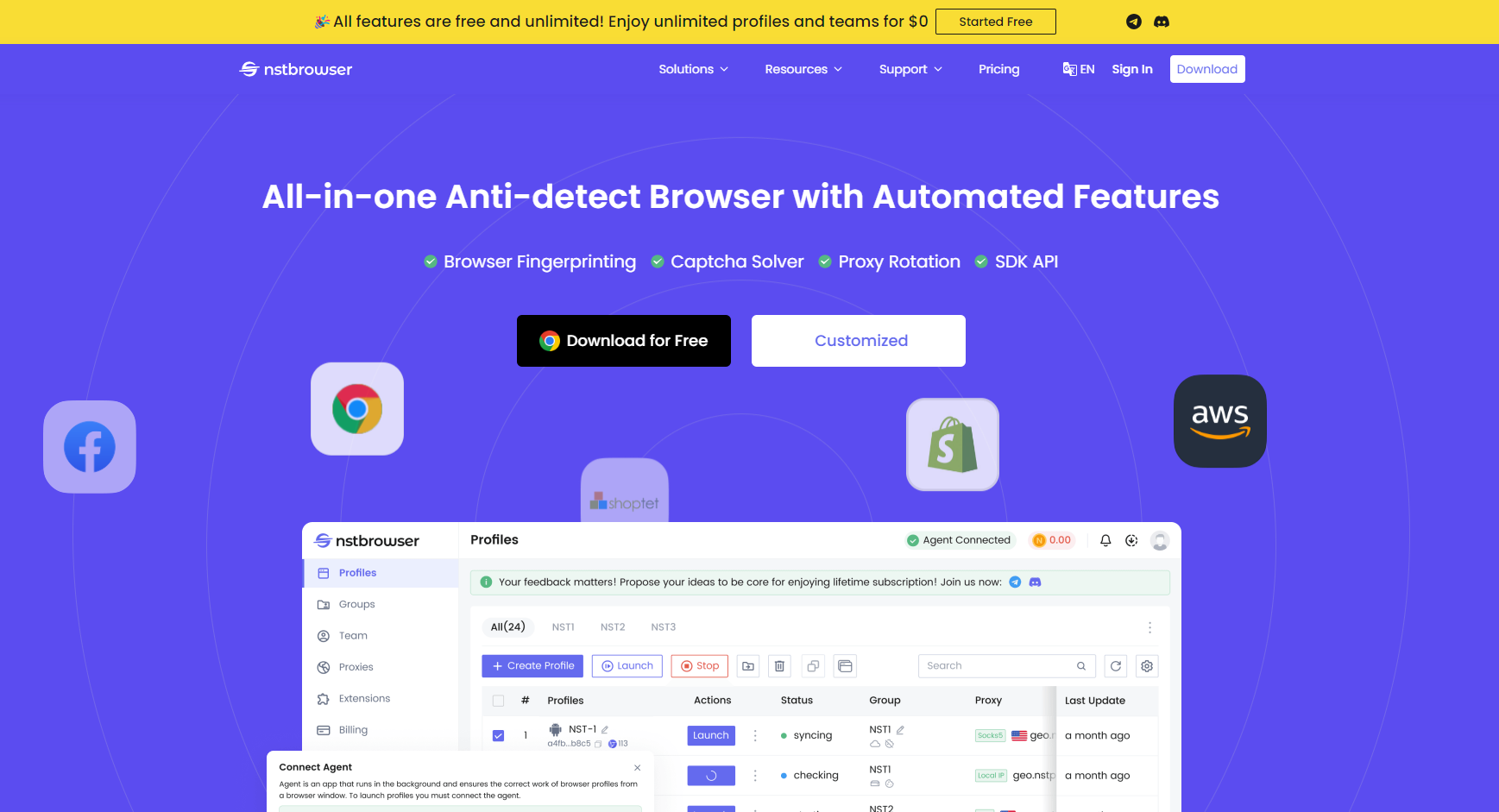

Web scraping usando Nstbrowser

¿Cómo hacer web scraping de manera eficiente y fácil? ¿Cómo evitar el bloqueo de sitios web y el reconocimiento de CAPTCHA? ¿Cómo minimizar el costo de hacer scraping de sitios web?

¡Nstbrowser puede resolver todos tus problemas!

Scraping de datos de alta calidad. Como un navegador anti-detección, Nstbrowser ofrece una infraestructura de última generación, desarrolladores talentosos y una experiencia extensa para asegurar que no haya datos faltantes ni incorrectos.

Desbloqueo completo de sitios web. Nstbrowser tiene el programa más completo de desbloqueo de sitios web. Puede desbloquear fácilmente sitios web con Web Unblocker, Captcha Solver, Intelligent IP Rotation y Premium Proxies, garantizando un web scraping sin interrupciones.

Gratis para usar. Nstbrowser ahora es un navegador de huellas dactilares completamente gratuito. Simplemente descárgalo e inicia sesión para experimentar perfiles ilimitados y configuraciones de entorno ilimitadas.

Cumplimiento legal. Puede que no conozcas todos los "deberes y no deberes" del web scraping, pero un proveedor de servicios de contra-inspección con un equipo interno de profesionales legales ciertamente sí. Nstbrowser se asegurará de que siempre cumplas con la legalidad.

¡Comienza tu prueba gratuita ahora!

¿Es legal el Web Scraping?

Se mencionó anteriormente asegurar la legalidad del web scraping. Entonces, ¿la actividad de web scraping en sí es legal?

En resumen, el acto de web scraping no es ilegal y no hay una ley específica contra el web scraping.

Sin embargo, hay algunas reglas que debes seguir. En algunos casos, el web scraping puede violar otras leyes o regulaciones, haciendo que el web scraping sea ilegal.

Por ejemplo:

- Usar una herramienta de web scraping para iniciar sesión en una página web o sitio web y luego descargar datos. Los usuarios que inician sesión en un sitio web deben aceptar los Términos de Servicio, que pueden prohibir actividades como la recopilación automatizada de datos.

- Scraping de datos públicos protegidos. Puede haber menos restricciones sobre el rastreo de datos públicos que sobre la información privada, pero aún así debes asegurarte de no violar las leyes que se aplican a tales datos, como descargar datos protegidos por derechos de autor, incluyendo diseños, diseños, artículos, videos y todo lo que pueda considerarse una obra creativa.

- Cuando los Términos de Servicio prohíben cualquier forma de recolección automatizada de datos. En este caso, no es el uso de los datos lo que es ilegal, sino la actividad de scraping en sí misma.

- Agarrar datos no públicos. Esto es claramente ilegal.

4 consejos generales para las mejores prácticas de web scraping

1. Usa APIs en lugar de scraping

Muchos sitios web proporcionan interfaces API especializadas para que los desarrolladores obtengan datos. Las APIs suelen ser más estables y eficientes que el crawling web, y colocan menos carga en el servidor web.

Así que, antes de desarrollar un scraper, averigua si el sitio web objetivo proporciona una interfaz API y revisa la documentación de la API. Si la API cumple con la demanda, prioriza el uso de la API para obtener datos.

2. Respeta los Términos de Servicio del sitio web

Los términos de servicio generalmente contienen las disposiciones del sitio web sobre el uso de datos y la recopilación de datos. La violación de estos términos puede resultar en problemas legales o prohibiciones.

Lee cuidadosamente los términos de servicio del sitio web objetivo antes de realizar el web scraping de datos. Si los términos prohíben explícitamente el crawling, no realices el scraping.

3. Respeta el archivo robots.txt

El archivo robots.txt instruye a los web scrapers sobre qué páginas se pueden rastrear y cuáles no. Aunque robots.txt no es un documento legal, respetarlo es una forma de netiqueta.

Al escribir un scraper, primero verifica y analiza el archivo robots.txt del sitio web objetivo. Puedes utilizar una biblioteca de análisis de robots.txt para hacer esto automáticamente.

4. Confirma la información de derechos de autor

Los datos rastreados pueden estar protegidos por derechos de autor. Usar o publicar estos datos puede violar las leyes de derechos de autor.

Así que, confirmar el estado de derechos de autor de los datos rastreados es muy importante antes de usarlos o distribuirlos. Si los datos están protegidos por derechos de autor, obtén permiso por escrito del propietario de los derechos de autor antes de usarlos o distribuirlos.

El Mejor Web Scraper

¡Genial! Ahora que conoces todos los conceptos básicos del web scraping, ¿cuál es el mejor web scraper para ti?

Recomendamos encarecidamente Nstbrowser.

No solo es gratuito descargarlo y usarlo, sino que también cuenta con un conjunto muy potente de características:

- Interfaz de usuario amigable

- Tecnología potente de desbloqueo de sitios web

- Capacidades eficientes de web scraping

- Excelente soporte al cliente

Más